シリーズ・コラム(第二回)LIQID CDIユースケース #1:1台のサーバーに20台のNvidia GPUを接続

シリーズ・コラム第二回。

前回のコラムでは、「サーバー間でGPUをネットワーク共有できる」というLIQID CDIの提供価値の一つを紹介した。今回はLIQID CDI製品のユースケースを紹介して、同製品の異なる提供価値を伝えられたらと願う。

プラットフォーマーの一つであるM社にLIQID CDIを採用いただいた。検討されていたサーバーは、高精細VR環境の再構成およびレンダリング用のサーバーであり、Nvidia GPU L40Sを20台必要とすることが予めわかっていた。またNUMA構成による潜在的なソフトウェア懸念を回避すべくシングルソケットサーバーが望まれた。いくつかのシステム設計案を比較検討された結果、単にシステム要件を満足するだけではなく、TCOが大きく削減できることが証明され、LIQID CDIが採用された。

GPUサーバーとLIQID CDIの比較

サーバーメーカー各社がラインナップするモダンなGPUサーバーには最大8台のGPUを搭載する仕様のものが多い。このユースケースのように20台のGPUを必要とする場合、例えば、これらGPUサーバーを3台導入する方針でシステム設計を行う場合の費用見積りは以下のようなものになる。

- 20台のGPUの調達コスト

- GPUサーバー 3台分の調達コスト

- GPUサーバー 3台分のCPU数/コア数に応じたソフトウエア・ライセンス費用

- GPUサーバー 3台分のCPU、メモリー、SSDなどのエネルギー(電力)コスト

- GPUサーバー 3台を外部接続するためのインフィニバンドやイーサネットなどのネットワーク機器

対してLIQID CDIではどのようなシステム構成になるか下の概念図をご覧いただきたい。

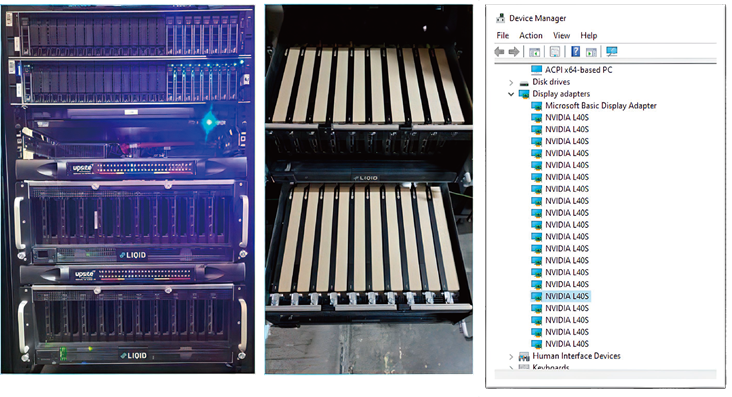

上からサーバー 、PCIeファブリック・スイッチ そしてGPUを集約(プール化)して搭載するための拡張シャーシ(JBOX) 2台である。拡張シャーシは、1台に10枚ずつ計20台のNvidia GPUを搭載する。PCIeファブリック・スイッチで接続されることで、サーバーと拡張シャーシのPCIeバスが「概念的に」シームレスに繋がり、拡張シャーシ内のGPUがあたかもサーバーのローカルバス上に存するように扱える。。

このLIQID CDI構成と上記のGPUサーバー構成案とを比較してみよう。GPUサーバー案では、20台のGPUを実装できるが、このユースケースでは、それ以外に大型のGPUサーバーを必要とする理由はなく、標準的な2Uサーバー 1台で十分満足できた。このことは、単にサーバーのハードウェアコストを圧縮しただけでなく、CPUコア数で計算されるソフトウェア・ライセンス費用も大幅に節減させた。もちろん、LIQID CDI構成では、拡張シャーシやPCIeファブリック・スイッチ、そしてCDI管理ソフトウェアのライセンスなどGPUサーバー構成案にはない要素が追加されるが、それでも導入後の運用コストと合わせたTCOは大きく低減できた。

固定観念を覆すGPU密度:1台のサーバーに20台のGPUを接続

1台のサーバーに20台のGPUを接続できるというのは、標準的なGPUサーバー製品の仕様からは考えにくいだろうが、LIQIDはCDIソフトウェアとPCIeネットワーク技術を融合することで実現した。以下は、実際に導入されたCDIシステムの画像である(GPUの搭載台数を可視化するために便宜的にWindows Device Managerで表示している)。

終りに、このユースケースの応用例を考えたい。例えば、手元に計10台のGPUを持っているが、それらは複数のサーバーあるいはワークステーションに分散導入されているとしよう。各マシン内のGPUはそのままでは他のマシンと共用できないが、LIQID CDIを導入しGPUを集約(プール化)すれば、必要な時に必要な数のGPUを(オンデマンドで)使用することができる。プール化したGPUリストの中から空いているGPUを選び、マシンに割り当てて(「コンポーズする」と言うが)使用し、使い終わったらプールに戻す。GPUに限らず共用したい資源さえプール化しておけば、その時々の必要に応じて、柔軟かつ瞬時にベアメタルサーバーを再構成できるのだ。

次回(第三回)のコラムでは、これまで二重に保有していたGPUを部門間でタイムシェアすることで大幅にTCOの削減に成功した実例を紹介したい。

(MF)