HDR製品のご案内#1 – ConnectX-6 VPI

8月後半にようやく HDR InfiniBand 製品がリリースになりました。本ブログでは、2回に分け、HDR InfiniBand 製品についてご案内させていただきます。

今回は、カード製品のConnectX-6 VPI についてご案内させていただきます。

ConnectX-6は、世界初の200Gb/s HDR InfiniBand およびイーサネットネットワークアダプターカードであり、世界をリードするパフォーマンス、スマートオフロード、およびインネットワークコンピューティングを提供します。 VPI対応のConnectX-6は、HDR、HDR100、EDR、FDR、QDR、DDR、SDR InfiniBandの速度と、200、100、50、40、25、10、1Gb/sのイーサネット速度をサポートし、200Gb/sの2つのポートを提供します。ConnectX-6は、600ナノ秒未満のレイテンシー、最大2億1500万メッセージ/秒、内蔵のPCIeスイッチ、およびNVMe over Fabricをサポートします。ConnectX の以前のバージョンに含まれていたほぼすべての機能に加えて、ConnectX-6は、ネットワークセキュリティの重要な革新として最大8台のホストとのマルチホストサポートとブロックレベルの暗号化を提供し、今日の厳しいアプリケーションと市場に最高のパフォーマンス、最も安全で非常に柔軟なソリューションを提供します。

ざっくりと記載すれば上記になりますが、もう少し説明させてください。

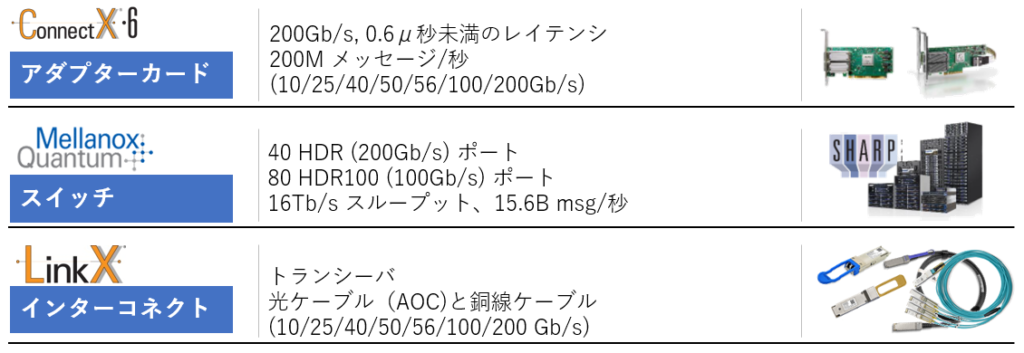

ConnectX-6 シリーズは、最大で200Gb/s HDR InfiniBand と、200Gb/イーサネット に対応、また100Gb/sでは、EDR、HDR100に対応する製品です。製品ラインナップとしては、既にリリース済みの、InfiniBand とEthernetに対応する「VPI (Virtual Protocol Interconnect)」版と、今後市場投入が予定されている Ethernetのみに対応する「En」版があります。また本シリーズのバリエーションとして特定の市場向けに一部の機能を強化した、ConnectX-6 Dx もすでに発表されています。

■ HDR/HDR100

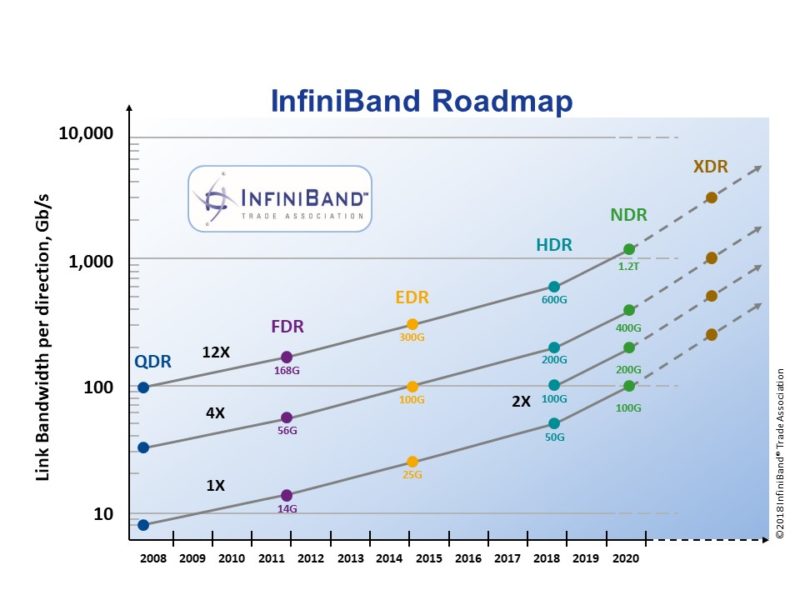

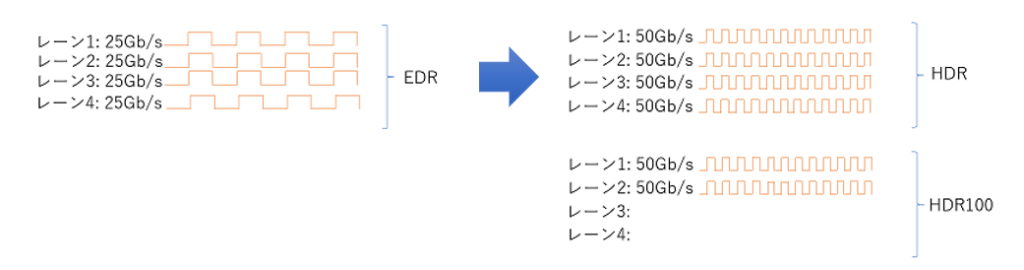

以下のInfiniBandの仕様を策定する団体 IBTA(InfiniBand Trade Association)が提供するInfiniBandのロードマップにあるように、HDR(High Data Rate) InfiniBandは、100Gb/sに対応するEDRの次の世代として定義された仕様であり、EDRの1レーン25Gb/sを4レーン束ねて、100Gb/sの転送レートを実現するのに対し、1レーン50Gb/sを4レーン束ねて200Gb/sの帯域幅を実現しています。

HDR100は、EDR、HDRが4レーンを束ねているのに対し、HDRの2レーン分のみを活用し、100Gb/sの転送レートを実現するものです。

同じ100Gb/s の転送レートですが、EDRとは、1レーンの帯域幅とレーン数が異なります。そしてこの仕様も上記ロードマップ上の2Xと記載されている部分にあるようにIBTAによって正式に定義されているInfiniBand仕様となります。なお、HDRもHDR100もコネクタの物理的なフォームファクタは、QSFPタイプとなり、HDRは、EDR、FDR、QDR…等との下位互換性を持ち、電気的な仕様のみ更新されたQSFP56と呼ばれる仕様を活用します。

■ カード形状とPCI Express(PCIe) 対応

200Gb/sの帯域幅を活用するため、PCIe Gen 4.0の対応が本格的になってきています。実は、1つ前のConnectX-5 の世代においても、「ConnectX-5 Ex」という少しプレミアム感のある名称で、PCIe Gen 4.0 対応のカードが既にリリースされていたのですが、ConnectX-6世代では、通常のConnectX-6シリーズの一つとして、PCIe Gen 4.0対応がなされています。また、標準のPCIeカードタイプの製品に加え、Socket Direct™、OCP 3.0 SFF(Small Form Factor)タイプの形状のカードも提供しています。

Socket Direct™は、元々はデュアルCPU構成のマザーボードに向けて、ケーブルで結ばれた2枚のカードをそれぞれのCPUに直結するPCIeスロットに挿入し、CPU間通信をバイパスすることで、レイテンシ性能を改善し、もう一つのCPUからCPU間通信でCPU上に流れ込むデータ量を削減するソリューションです。ConnectX-6では、新たに最大で 32レーンのPCIe のサポートが提供されたことにより、PCIe Gen3.0 対応のマザーボードにおいて、上記の2枚刺しのSocketDirectカードによってPCIe側での200Gb/sの帯域幅を確保する目的が追加されています。

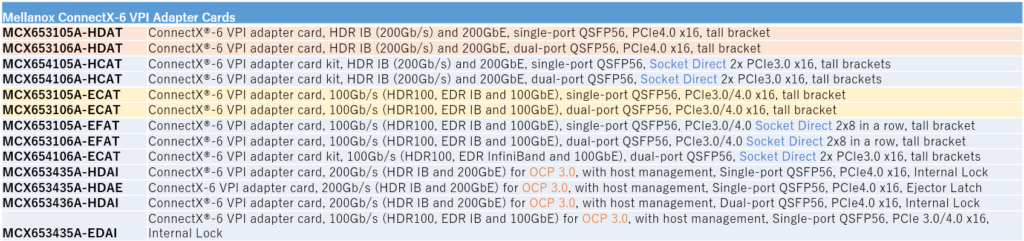

次のチャートは、ConnectX-6 VPI シリーズの現行(2019年9月時点)のラインナップとなります。

■ HPC-AI性能

カードの性能の指標となる、メッセージレートは、PCIe Gen 3.0 仕様のConnectX-5 の175M(Million) Message/secや、ConnectX-5 Exの200M Message/secに対し、ConnectX-6では、215M Message/secと向上しており、また、0.6μ秒未満のレイテンシー性能を提供しています。今回ConnectX-6 VPIでは、明示的に新たなオフロードエンジンの追加はございませんが、MPI 通信時に受け取ったデータをメモリに格納する際、タグで管理されたメモリ領域の検索をCPUからオフロードするMPIタグマッチング、またランデブープロトコルのオフロードなどこれまでのオフロード機能をすべて搭載し、更にGPGPU カード内のメモリをより効率的に他ノードに転送するGPUDirect™もCPUではなくGPGPU自体のおぜん立てによりConnectXシリーズのカードへのデータ転送の準備が行われるようになり、また、スイッチとの組み合わせで経路パスを動的に変更することでMPI演算の性能を向上させるSHArPもMPIよりもメッセージ単位のより大きな機械学習に対応するSHArP2になるなど、HPC 及びAI分野において、Mellanox は様々なレイヤーにおいて、より効率的にデータ転送を行うためのソリューションを提供し続けています。

■ セキュリティ

「EU一般データ保護規則」、通称「GDPR」などデータ漏洩に対し、莫大な罰金が科される罰則規定が設けられた規則が既に施行されておりクラウド環境でのデータ保護はいっそう強く求められています。そのため、ConnectX-6では、従来からサポートされている、T10 DIF シグナチャーハンドオーバー、消失訂正符号(Erasure Coding)、NVMe、NVMe ターゲット等に対する様々なオフロード機能に加えて、クラウド環境で要求されるATS-XTS 256/512ビットキーでのストレージの暗号化に対応するオフロード機能が追加されています。加えて、ConnectX-6 VPIは、FIPS (Federal Information Processing Standards :連邦情報処理規格)に準拠しています。

また、デバイス固有のキーに基づいたHMAC(Keyed-Hashing for Message Authentication:メッセージ認証のための鍵付ハッシング)を活用したハードウェアでの「信頼の起点」(Root-of-Trust)を採用しています。これにより、クローン保護と同様にシステム起動時のシステムの一貫性(認証されていないソフトが実行されるのを防ぎ、改ざんされていないこと)を保障する、セキュアブートもサポートします。

■ マルチホスト機能

ConnectX シリーズのカードは、1枚のカードのPCIeレーンを分割し複数のホストの接続を許容するマルチホスト機能に対応しています。OCP(Open Compute Project)環境など、マルチホストが許容されるサーバシステム等において、ConnectX-6シリーズでは、1枚のカードで最大8つのホストとの接続を可能としています。

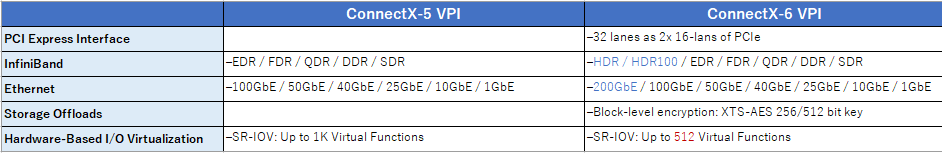

上記は、ConnectX-6 VPI 製品ブローシャ(53486PB Rev 1.8)とConnectX-5 VPI製品ブローシャ(53635PB Rev 2.0)のCompatibility及びFeatures 部分の比較で、異なる表記となっている部分のみを抜粋。OSとHPC Software Libraries項は、それぞれ直接ハードの違いに依存しない部分であるため非掲載。

今回は、ConnectX-5との比較で変更となった部分を中心にConnectX-6 VPI 製品についてご案内させていただきました。次回は、HDRのスイッチ製品、ケーブル製品についてご案内させていただく予定です。